Cómo la inteligencia artificial está afectando a nuestra ciberseguridad

Desde hace meses hemos visto que la inteligencia artificial, y más concretamente implementaciones como la que propone ChatGPT, están en boca de todos. No cabe duda de que la posibilidad de interactuar de forma sencilla con una IA de este estilo y que muestre resultados bien redactados y coherentes es un avance destacable. Sin embargo, como con todos los avances también estamos empezando a ver su lado oscuro, especialmente por el uso malicioso o irresponsable que están haciendo algunos delincuentes y usuarios.

Nuevas versiones, nuevas posibilidades

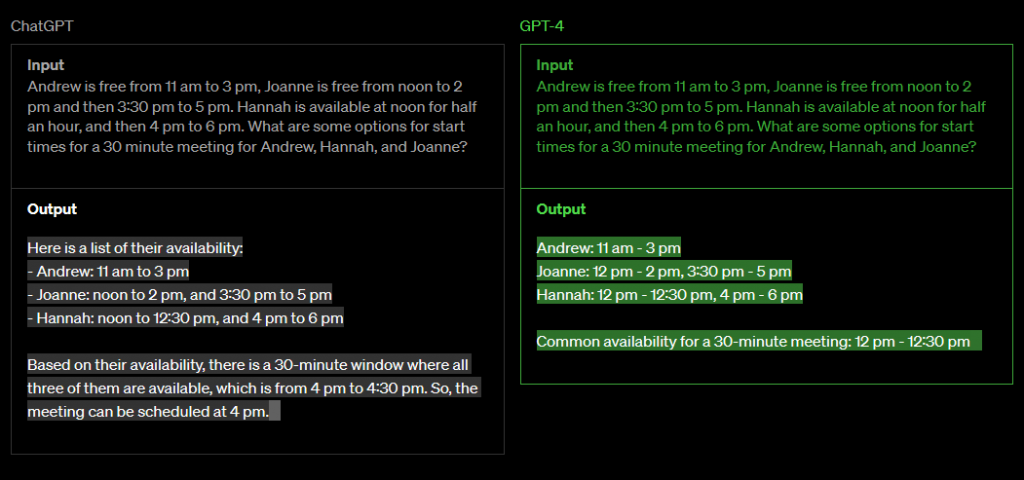

El pasado 14 de marzo se lanzaba públicamente GPT-4, una versión más avanzada de la IA que ha revolucionado a todo el mundo desde que se permitió acceder a ella de forma pública en noviembre de 2022 en su versión GPT-3. Obviamente, ya hay usuarios que se han lanzado a comprobar las mejoras implementadas en esta nueva versión, y la propia empresa desarrolladora se ha apresurado a mostrar ejemplos donde se ve claramente cómo supera a su predecesora.

Obviamente, y viendo el revuelo que produjo el lanzamiento de ChatGPT hace unos pocos meses, la empresa OpenAI espera conseguir más beneficios e inversores con las implementaciones de su nuevo modelo de inteligencia artificial. Pero no debemos olvidar que esta tecnología, además de ayudarnos en múltiples tareas, también puede ser usada en nuestra contra por todo tipo de delincuentes.

Hace un par de meses escribíamos acerca de las posibilidades que ofrecía ChatGPT a la hora de generar tanto correos de phishing como código malicioso. Estas posibilidades ya han sido aprovechadas por algunos delincuentes en sus campañas de propagación de malware, y es de esperar que lo sigan haciendo durante los próximos meses a pesar de las limitaciones que la empresa desarrolladora está imponiendo para evitar que se use su modelo de IA de forma maliciosa.

Engañando a la vista

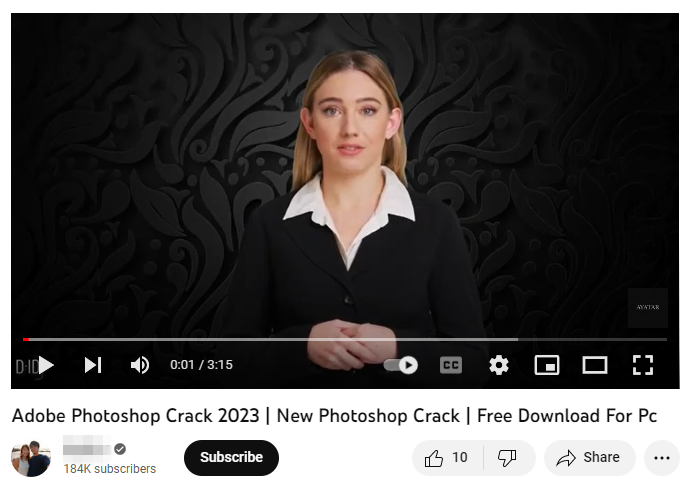

GPT puede ser la IA del momento, pero no es la única que existe, ya que hay muchas otras empresas desarrollando sus propios modelos, algunos de ellos centrados en campos específicos como el de las imágenes o la reproducción de voz. Este amplio abanico de posibilidades permite contar con varias opciones a la hora de preparar un ataque y explotar el hecho de que muchos usuarios no son capaces de distinguir entre contenido real y el generado por una IA. Como ejemplo, tenemos campañas de propagación de malware especializado en el robo de información que utilizan vídeos en Youtube generados por inteligencia artificial y que se hacen pasar por tutoriales para la descarga de versiones pirateadas de software de pago como Photoshop, Premiere Pro, Autodesk 3ds Max o AutoCAD, por poner solo algunos ejemplos. Entre las credenciales que roban se encuentran las que utilizan algunos usuarios para acceder a su canal de YouTube, con lo que los delincuentes consiguen aumentar su propagación y conseguir nuevas víctimas.

El uso de vídeos de Youtube como gancho para propagar malware y todo tipo de estafas no es algo nuevo, pero estamos viendo cómo se extiende la utilización de imágenes generadas por inteligencia artificial, concretamente aquellas que muestran a personas con ciertos patrones que generan confianza entre los usuarios que las visualizan. Además, con la suplantación de voz se pueden llegar a preparar campañas de vishing muy efectivas que no permiten a las víctimas distinguir entre la voz real de un conocido y la generada por una IA.

Precisamente, la utilización de imágenes y, concretamente, rostros generados por una inteligencia artificial, es algo que se ha venido mejorando considerablemente en los últimos años. Con estos rostros falsos, los delincuentes pueden, por ejemplo, generar perfiles falsos en redes sociales para engañar a posibles víctimas y conseguir que revelen información personal, crear noticias falsas para desinformar sobre temas concretos, robar la identidad de personajes públicos para ganarse la confianza de sus allegados o incluso realizar fraudes en aplicaciones de citas, llegando a estafar importantes cantidades de dinero usando este método.

Otros riesgos

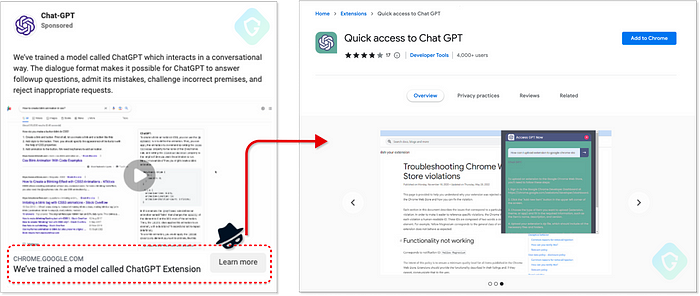

Además del uso de imágenes y audios que pueden llegar a ser indistinguibles de los reales, el interés por las nuevas aplicaciones que puede tener la inteligencia artificial ha hecho que los delincuentes traten de conseguir nuevas víctimas entre aquellos que buscan una forma sencilla de aprovechar todas sus bondades. Por ese motivo, no es de extrañar que encontremos extensiones maliciosas de navegadores como Chrome que prometen acceso rápido y sin complicaciones a todas las ventajas que ofrece ChatGPT.

Y aunque algunas de estas extensiones cumplan lo que prometen ofreciendo conectarse a la API de ChatGPT, por el camino van robando credenciales de todo tipo de servicios online, como pueden ser las credenciales de nuestra cuenta de Facebook. Como vemos, la técnica es conocida desde hace años, pero los delincuentes le han dado una vuelta de tuerca aprovechando el interés creciente que hay alrededor de las IA.

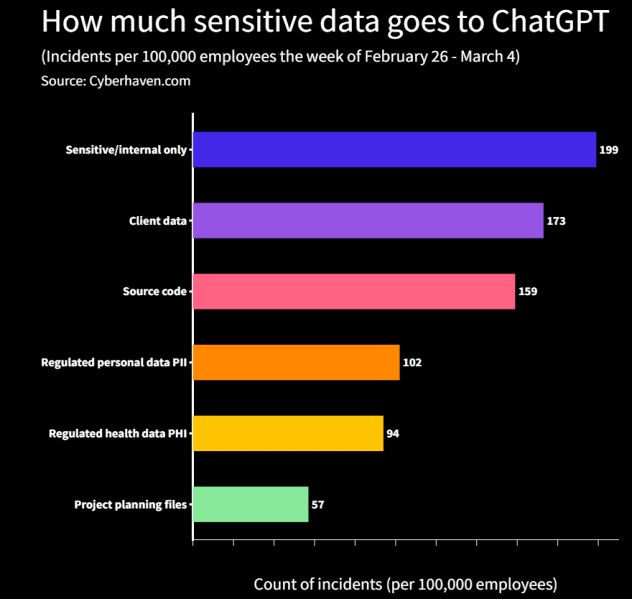

Por parte de los usuarios, estos también deben andarse con cuidado cuando usan servicios como ChatGPT y comparten en ellos información confidencial relacionada con su puesto de trabajo o empresa. Si bien ChatGPT no tiene la capacidad de almacenar esta información confidencial, esta información podría ser vulnerable a posibles riesgos relacionados con la privacidad y seguridad a la hora de usarla online en este tipo de servicios.

Por último y para aportar una parte positiva del uso de la IA en el ámbito de la ciberseguridad, las empresas como ESET que llevan décadas trabajando en este campo comenzaron a implementar sus propios modelos de inteligencia artificial para detectar amenazas hace mucho tiempo, y los han ido evolucionando desde entonces para que resulten más efectivos contra las amenazas que cambian constantemente.

Conclusión

Es normal que muchos de nosotros busquemos aplicaciones prácticas a los modelos de inteligencia artificial que han ido apareciendo en los últimos años. No obstante, no debemos olvidar que estas IA también pueden ser usadas en nuestra contra y debemos permanecer atentos para evitar caer en las trampas, cada vez más perfeccionadas, que los ciberdelincuentes están preparando.