Las nuevas medidas contra la pornografía infantil amenazan la privacidad de los usuarios

Durante los últimos días ha habido bastante revuelo tras conocerse que Apple analizará las fotos que los usuarios almacenan en sus dispositivos para buscar material que sea considerado como pornografía infantil. Esta medida, unida a una normativa europea aprobada hace poco, hace que nos planteemos cómo afecta directamente a la privacidad de los usuarios o incluso si el fin justifica los medios.

Revisión de imágenes en dispositivos Apple

El anuncio de Apple ha pillado a mucha gente por sorpresa, especialmente después de que la empresa haya estado promocionando la privacidad como uno de los puntos fuertes de sus dispositivos. Sin embargo, la lucha contra la difusión de la pornografía infantil ha servido de excusa para implementar un sistema de análisis de imágenes en los dispositivos de Apple que permitirá buscar coincidencias entre aquellas imágenes que se encuentran en una base de datos de contenido pedófilo y las que los usuarios hagan, almacenen o compartan.

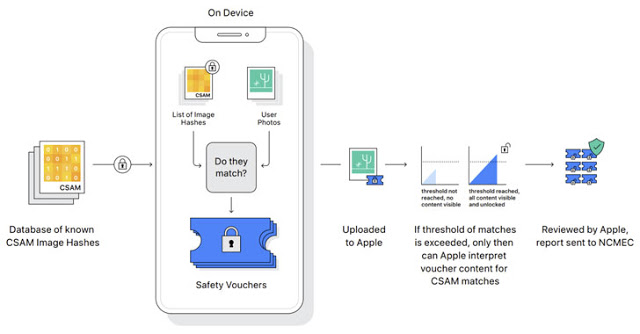

La idea de Apple es implementar este análisis antes de que finalice este 2021 y el mecanismo utilizado pasa por comparar los hashes de las imágenes, no las imágenes en sí. Estos hashes son el resultado de una operación criptográfica que genera identificadores supuestamente únicos, más o menos robustos dependiendo del algoritmo empleado.

Así pues, al comparar estos hashes la fiabilidad de encontrar las coincidencias será muy elevada, siempre según Apple. Tan solo cuando se haya excedido cierto nivel de coincidencia entre las imágenes almacenadas en el dispositivo del usuario y las presentes en la base de datos de imágenes con contenido pedófilo, las imágenes sospechosas serían revisadas por personal de Apple y, en caso de confirmarse una coincidencia, se desactivaría la cuenta del usuario y se enviaría un informe al Centro Nacional para Niños Perdidos y explotados de los Estados Unidos.

Debemos recordar que este tipo de análisis ya se estaba realizando en servicios de almacenamiento como iCloud o los proporcionados por Google o Microsoft. La novedad es que, desde el momento en que se implante esta nueva medida, el análisis también se realizará en el propio dispositivo del usuario.

ChatControl, perdida de privacidad en Europa

De momento, la revisión de las imágenes en dispositivos Apple va a implementarse primero en los Estados Unidos, aunque en Europa ya se aprobó el pasado mes de julio una normativa que permite a los proveedores de servicios como el correo electrónico o la mensajería instantánea buscar entre todos los mensajes de los usuarios con la finalidad de encontrar contenido potencialmente sospechoso.

El problema es que la intención de la Comisión Europea es la de hacer obligatoria esta revisión masiva de conversaciones por chats y emails este otoño, obligando, de facto, a las empresas que proporcionan estos servicios a permitir el acceso a las comunicaciones de sus usuarios.

A pesar de que muchos usuarios podrían pensar que esta nueva normativa no les afecta puesto que ellos no comparten material pedófilo, hemos de recordar que las decisiones las toman algoritmos que no tienen por que ser infalibles.

De esta forma, si uno de estos algoritmos considera que el contenido de los mensajes es sospechoso, tanto las fuerzas policiales como los empleados de las empresas contratados para revisar este material podrían tener acceso a conversaciones e imágenes privadas. Esto podría implicar que un usuario fuera falsamente acusado de compartir material pedófilo y fuera investigado por las autoridades, pudiendo incluso tener serios problemas al tratar de acceder a otros países dentro y fuera de la Unión Europea.

Tampoco debemos olvidar que, una vez abierta la puerta a permitir este tipo de investigaciones, tanto los ciberdelincuentes como gobiernos autoritarios podrían usar esta puerta trasera en las aplicaciones de mensajería y servicios de email para espiar a ciertos usuarios. El problema es que de momento solo se menciona la lucha contra la pedofilia, pero la clasificación de material “sospechoso” podría cambiar e incluir otro tipo de contenido que un gobierno o incluso una empresa privada considere peligroso para sus propios intereses.

¿Quién vigila a los vigilantes?

De nuevo nos encontramos ante una situación peligrosa por la posibilidad de que este control de las comunicaciones y lo que compartimos a través de ellas se vaya de las manos, y lo que empezó siendo una medida para luchar contra la pedofilia o el terrorismo termine en un control indiscriminado de la población.

Esto es algo que hemos visto en ocasiones anteriores a la hora de, por ejemplo, tratar de prohibir o limitar el cifrado de datos o comunicaciones. De hecho, ni los algoritmos más avanzados pueden garantizar que no vayan a equivocarse y acusen a una persona inocente de estar cometiendo un delito. Esto no es algo improbable, puesto que las técnicas para romper los algoritmos capaces de comparar hashes de imágenes se conocen desde hace años.

Por otro lado, la cuestión sociocultural también es un punto importante a la hora de decidir qué es contenido inapropiado. En España, por ejemplo, no es extraño ver como muchos padres hacen fotografías a sus hijos de corta edad bañándose desnudos en la playa o la piscina, incluso compartiendo estas fotografías en chats con familiares o amigos y, en algunos casos, publicándolas en redes sociales.

Este sería un claro ejemplo donde los algoritmos implementados para reconocer este tipo de imágenes seguramente fallarían, obligando a una revisión por parte de una persona de las imágenes sospechosas, persona que no tiene por qué conocer las costumbres locales y puede lanzar una alerta que podría poner en serios problemas al progenitor que realizó la fotografía y la compartió.

Conclusión

Como ha sucedido en otras ocasiones, la implementación de este tipo de peligrosas medidas que atentan de forma directa contra la privacidad de los usuarios se vende inicialmente como algo que nos ayudará prevenir delitos tan deleznables como la explotación sexual infantil y la compartición de material pedófilo.

Sin embargo, una vez abierta esta puerta a la vigilancia masiva, es difícil decir dónde está el límite y quién puede emplear esta vigilancia con otros propósitos menos éticos, por lo que, como usuarios, debemos exigir que se realice un control estricto de quién y cómo utiliza estas capacidades de vigilancia para evitar abusos.